Zapraszamy do lektury drugiego artykułu z serii poświęconej tematyce sztucznej inteligencji w branży foto. Autorem tekstu jest Michał Rozner, ambasador marki SONY w CEWE FOTOJOKER

Bez luster i bez kompromisów

Aparaty bezlusterkowe to powiew świeżości na zatęchłym rynku fotograficznym, od lat pełnym tych samych, wielkich, czarnych, niezbyt estetycznych konstrukcji. Po obecnej sytuacji na całym rynku foto-video widzimy, jak bardzo ten powiew był przez wszystkich wyczekiwany. Innowacyjne rozwiązania technologiczne, które z przyczyn technicznych i konstrukcyjnych nie mogły być zaimplementowane w aparatach lustrzankowych, w bezlusterkowcach nie miały już takich ograniczeń. I się porobiło – lustrzanki, wieloletni synonim jakości fotograficznej znajdują się obecnie w odwrocie, aparaty bezlusterkowe z generacji na generację są coraz bardziej uniwersalne, coraz bardziej innowacyjne i coraz bardziej zaskakują możliwościami nawet recenzentów, którzy chcąc nie chcąc, musieli uznać ich wyższość i zauważyć potężne tąpnięcie, które spowodowały na rynku foto-video. Nie przesadzę stawiając tezę, że bezlusterkowce to największa rewolucja w branży od momentu skoku z fotografii analogowej w epokę cyfrową.

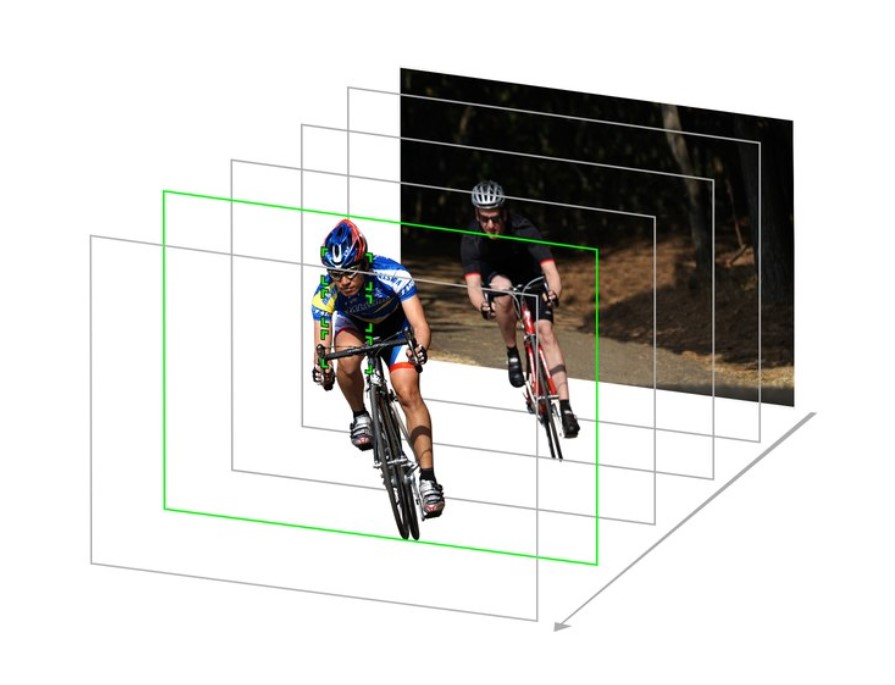

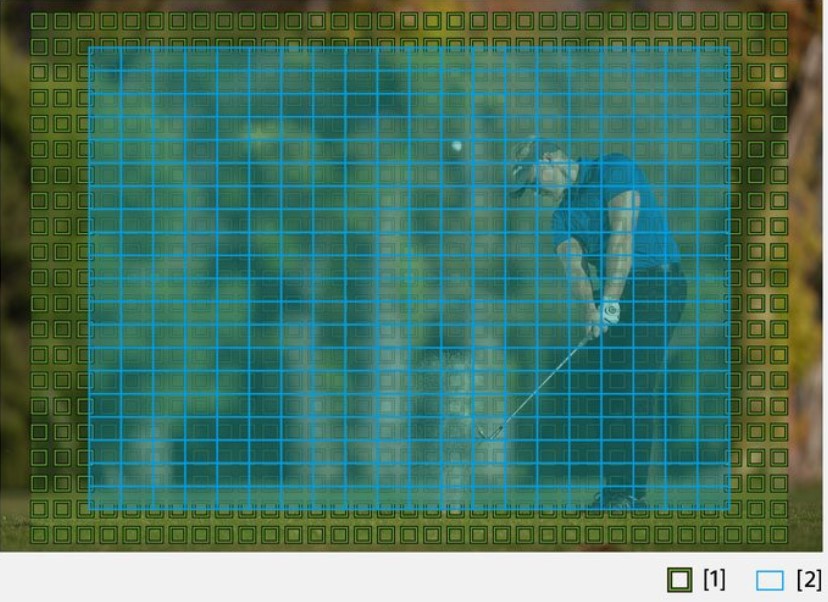

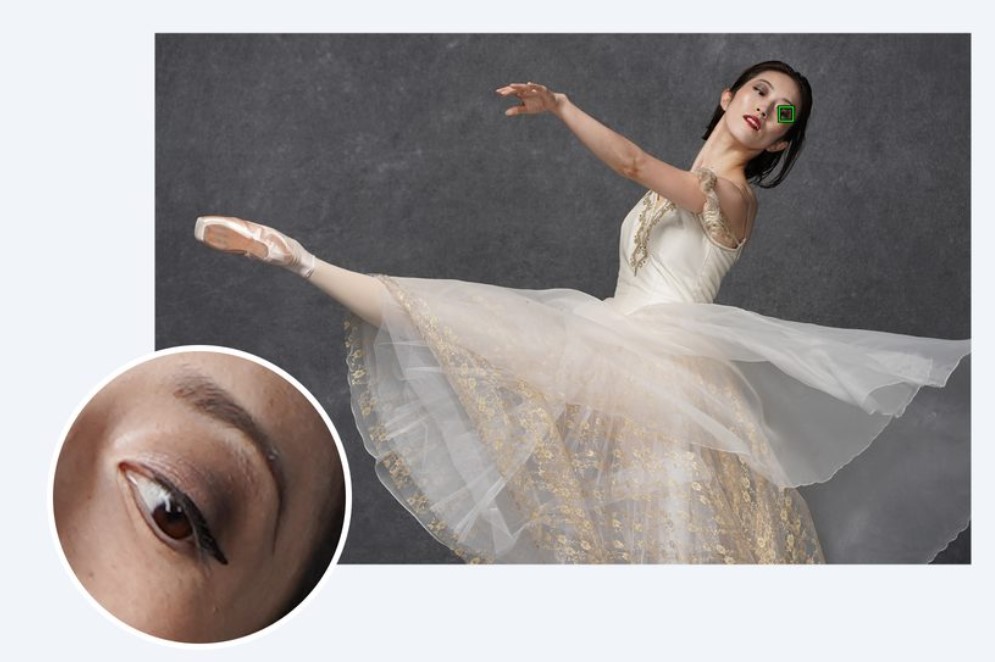

High-density Tracking AF – zaawansowany system śledzenie obiektów opracowany przez Sony. Zielone kwadraty to to, co widzimy na ekranie podczas działania AF, kwadraty szare to algorytm przewidujący ruch i korygujący ostrość w ułamku sekundy.

SONY α6400 – aparat na miarę oprogramowania

Firma wiodąca prym w rozwoju technologii bezlusterkowej i technologii matryc – Sony – uważa, że wciąż można robić bezlusterkowce lepiej – tchnąć w obecne modele nowe życie projektując zupełnie nowe rozwiązanie programowe. Tak narodził się najświeższy model z serii szóstej – α6400, o którym pisałem wcześniej na blogu (fotojoker.pl/blog) w artykule „SONY α6400 – nowość czy już innowacja?” gdzie podjąłem się zestawienia doskonałych i bardzo nowatorskich rozwiązań programowych opracowanych przez Sony, kontrastując je ze współczesną problematyką odgrzewanego kotleta. Najistotniejszym aspektem modelu α6400 jest fakt, że jest to właściwie model α6300. Zmian sprzętowych jest tak mało, że mogło by ich nie być, ale jest nowe oprogramowanie wsparte sztuczną inteligencją i jest nowy procesor, który to wszystko w ułamku sekundy przelicza – i to naprawdę robi dużą różnicę.

Algorytmy AF w bezlusterkowcach Sony przewidują ruch obiektu, koncentrując się na akcji – inne obiekty w kadrze nie zakłócają działania systemu, ustawia ostrość w ułamku sekundy

Co zatem dostajemy w nowym modelu? Dwie kluczowe funkcje, tworzące prawdziwe monstrum, jakim jest nowy system autofocus od Sony. Real-Time Tracking, czyli śledzenie obiektów w czasie rzeczywistym mogące działać jednocześnie z systemem Real-Time Eye AF (ustawianie ostrości na oko w czasie rzeczywistym) – funkcje rozpoznają obiekty w oparciu o sztuczną inteligencję, analizują kształt, kolor, odległość od obiektu (głębię) i wzór (jasność) jako informacje przestrzenne i w czasie rzeczywistym przewidują położenie preferowanego oka (lub obiektu w przypadku Real-Time Tracking), aby dokładnie ustawić na nim ostrość oraz jednocześnie dbają o dokładne uchwycenie wszystkich elementów sceny.

Funkcja 4D Focus natychmiast wykrywa odległość od obiektu i ustawia ostrość w ułamku sekundy

Nie mogę się oprzeć przekonaniu, że w przypadku Sony α6400 to nie aparat był bazą tylko oprogramowanie. Tworzenie aktualizacji software’u dla pełnoklatkowych modeli α9, α7 III, α7r III było początkową fazą – później ktoś wpadł na pomysł, że te funkcje powinny zawitać również w systemie APS-C. Wzięto model α6300, wsadzono weń najnowszy procesor BIONZ X, żeby aparat nadążył z obliczeniami, dodano jeden zawias więcej na odchylanym ekranie i voilà – można pociągnąć białą farbą α6400 na tej samej magnezowej obudowie. To oczywiście moje gdybanie, ale mam nieodparte wrażenie, że tak właśnie było. Sony α6400 to aparat stworzony zmodyfikowany na potrzeby oprogramowania. Czy to źle? W tym przypadku niekoniecznie.

SONY α9 REBORN – oprogramowanie na miarę aparatu

Nowe oprogramowanie Sony tworzone było z myślą o flagowym modelu α9, który dysponuje ogromnym potencjałem sprzętowym. Aktualizacja 5.00, w przypadku α9, tak bardzo usprawnia pracę jednego z najlepszych systemów autofocus na świecie i wnosi tyle nowych funkcji w specyfikację aparatu, że zyskała oficjalną nazwę „α9 REBORN”! To chyba pierwszy przypadek, kiedy nowa wersja oprogramowania układowego w aparacie fotograficznym zyskuje własne, marketingowe nazewnictwo. Czyżbyśmy mieli do czynienia z nową erą w oprogramowaniu aparatów – taką na wzór komputerowych systemów operacyjnych, gdzie nazewnictwo aktualizacji jest dosyć powszechne? Z odpowiedzią na to pytanie musimy jeszcze poczekać, ale miejmy nadzieje, że aktualizacje oprogramowania w aparatach będą wnosiły równie dużo usprawnień, co duże aktualizacje komputerowych systemów operacyjnych, a nie tylko wsparcie dla obsługi nowych obiektywów. Wówczas odrębne nazewnictwo ma spory sens – pozwala łatwiej odróżniać oprogramowanie zawierające dane funkcjonalności i usprawnia proces komunikowania aktualizacji użytkownikom.

Sony α6400 – wielozadaniowy bezlusterkowiec z AI.

W przypadku flagowego modelu α9 proces aktualizacji przebiegnie dwuetapowo. Obecnie dystrybuowana jest wersja 5.00 wprowadzająca m.in. Real-Time Tracking i Real-Time Eye-AF, a w okresie wakacyjnym pojawić ma się wersja 6.00 wspierająca funkcję ANIMAL EYE-AF (rozpoznawanie i ustawianie ostrości na oczy zwierząt) – i tutaj musimy się chwilkę zatrzymać, gdyż funkcja ta jest przykładem wykorzystania sztucznej inteligencji i uczenia maszynowego w bardzo szerokim i skomplikowanym zakresie.

Animal Eye-AF to zapowiedziany przez Sony złożony system autofocus rozpoznający oczy zwierząt i ustawiający na nich ostrość. O ile ze zwykłym Eye-AF (tym zorientowanym na ludzi) nie ma problemów – każdy człowiek ma mniej więcej taką samą budowę fizyczną i niemal u każdego, oczy znajdują się na twarzy, a sama twarz też ma cechy wspólne dla gatunku ludzkiego, o tyle ze zwierzętami sprawa się komplikuje. Trudno uznać koci pyszczek za noszący wspólne cechy fizyczne z głową lecącego gągoła albo pójdźki ziemnej. A to wszystko przecież ma oczy, które aparat musi znaleźć i perfekcyjnie, w ułamku sekundy, ustawić na nich ostrość. Wiele źródeł wskazuje na to, że Sonowski system Animal Eye-AF będzie zarządzany przez algorytmy sztucznej inteligencji wspieranej uczeniem maszynowym i analizą danych (zdjęć zwierząt) wgranych wraz z aktualizacją do pamięci aparatu. System A.I. będzie aktywnie porównywał obraz w kadrze z zapisaną bazą danych zawierającą wzory zwierzęcych pysków (głów), a uczenie maszynowe będzie zbierać informacje o użyciu systemu AF na fotografowanym zwierzęciu, wykorzystanym profilu z bazy danych aby następnie usprawnić cały proces w oparciu o analizę fotografii użytkownika.

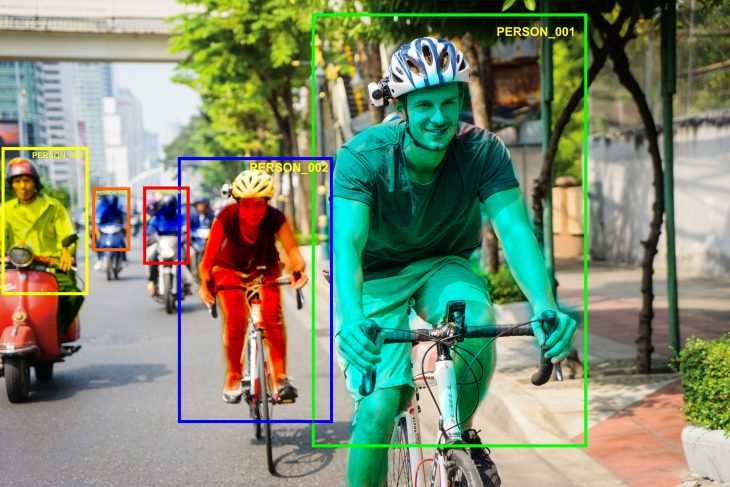

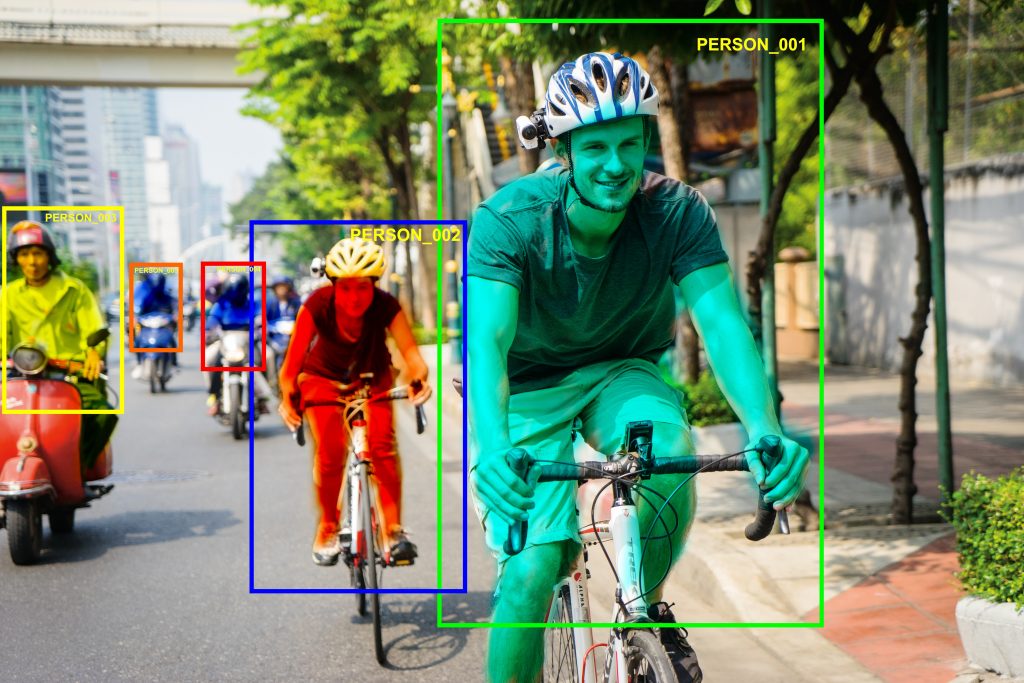

Obrazowe działanie algorytmów AI – maski segmentacyjne, rozpoznawanie obiektów (ludzi).

O ile zwykłe wykorzystanie sztucznej inteligencji obejmuje analizę obrazu w oparciu o takie procesy jak wykrywanie krawędzi i obiektów 3D, maski segmentacyjne, transformacje kolorystyczne, czy analizę semantyczną, o tyle w przypadku funkcji Animal Eye-AF koniecznym jest zastosowanie dodatkowej bazy danych. To przełomowe rozwiązanie budzi jednak moje obawy – większość skomplikowanych algorytmów sztucznej inteligencji obecnych w naszym życiu codziennym (np. asystent głosowy, rozpoznawanie mowy) wymagają stałego połączenia z Internetem – właśnie po to by dokonać obliczeń w oparciu o ogromne bazy danych, których na żadnym smartfonie ani w jakimkolwiek aparacie nie zmieścimy. Obawiam się, że próba uczynienia z α9 nowej Arki Noego, mieszczącej wszystkie gatunki zwierząt może być skazana na porażkę. Nie można też wykonać obliczeń w chmurze, bo przed każdym zdjęciem aparat musiałby przesłać dane na zewnętrzne serwery celem przeprowadzenia analizy i uzyskania odpowiedzi. Dopiero wówczas mógłby robić zdjęcie – teraz wyobraźmy sobie wszystkie te obliczenia wykonywane przy prędkości jaką dysponuje omawiany model– 20 kl/s. Nierealne.

693 punkty detekcji fazy oraz 425 punktów detekcji kontrastu – najbardziej zaawansowany system AF od Sony.

Czy zatem implementacja A.I. w przypadku nowego oprogramowania Sony jest bez sensu? Z kilku powodów absolutnie nie.

Po pierwsze – mamy trochę obśmianą α6400, kierowaną do użytkowników zaawansowanych albo entuzjastów fotografii. Algorytmy zastosowane w aparacie mocno porządkują wprowadzone w poprzednim modelu innowacje, takie jak Eye-AF i High-density Tracking, a rozwój technologiczny aparatu (mimo że trochę marginalny) jest mocno skorelowany z potrzebami wynikającymi z aktualizacji oprogramowania. α6400 wsparta systemem sztucznej inteligencji to bardzo uniwersalny aparat, który zadowoli entuzjastów, ale też pozwoli zaszaleć amatorom.

Po drugie, arcypotężny i profesjonalny model α9, dostaje narzędzie wykorzystujące potencjał jego podzespołów i szalenie szybkiej matrycy. Wraz z wprowadzeniem szeregu funkcji dla zawodowców aparat zyskuje nowe życie – α9 Reborn, czyli w starym ciele, nowy duch!

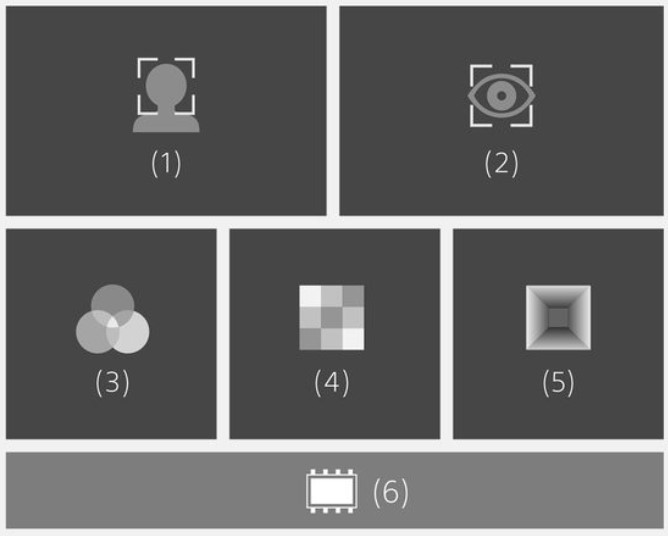

Nowy algorytm rozpoznawania obiektów oparty na AI przetwarza w czasie rzeczywistym informacje na temat twarzy [1], oczu [2], koloru [3], wzoru [4], oraz odległości przedmiotu [5] pozwalając na bardzo dokładne rozpoznawanie obiektów.

I po trzecie – oprogramowanie zostaje wydane również dla trzecich generacji serii 7, czyli uniwersalniej i bardzo popularnej α7 III oraz dla jednego z najlepszych wysokorozdzielczych korpusów α7R III. Oba aparaty mają ogromny potencjał technologiczny, któremu dotychczasowe oprogramowanie nie pozwalało uwolnić drzemiących w nim mocy – do teraz.

We wszystkich wymienionych przeze mnie przypadkach, zarówno sztuczna inteligencja jak i elementy uczenia maszynowego, są niemal idealnie skorelowane z możliwościami urządzeń i czasem ich życia na rynku. Jeśli tworzenie aparatów określanych mianem A.I. Camera ma przebiegać w ten sposób, to ja jestem obiema rękami ZA. Proces tej wielkiej aktualizacji oprogramowania od Sony można podsumować krótko: z szacunku dla użytkowników, z szacunku dla fotografii.

Tam, gdzie rodzą się marzenia…

Odpowiedzi na pytanie, co nam daje wprowadzanie i upowszechnianie sztucznej inteligencji w branży fotograficznej jest kilka. Na pewno obniża się próg wejściowy w dziedzinę jaką jest fotografia. Przed erą smart-oprogramowania i A.I. zrobienie dobrego zdjęcia wymagało znajomości tematu fotografii i obsługi aparatu. Obecnie nie ma takiej konieczności – owszem, wysokojakościowe rezultaty wciąż osiągniemy tylko i wyłącznie przy użyciu wysokiej klasy sprzętu fotograficznego, ale mamy też inny wybór. Możemy fotografować urządzeniami mobilnymi, naszpikowanymi oprogramowaniem podnoszącym jakość naszych zdjęć. W tym aspekcie sztuczna inteligencja stwarza nowe możliwości osobom, które bez niej nie zrobiłyby dobrego zdjęcia, albo zdjęcia w ogóle. Jedna czy druga babcia, dzięki zaawansowanemu oprogramowaniu w smartfonach, może zrobić i mieć przy sobie zdjęcia na przykład z wesela wnuczki, które chętnie pokaże ciotce podczas wieczornej partyjki kart przy lampce koniaku.

Pisałem o tzw. social media ready photo – zdjęciu gotowym do publikacji natychmiast. Dzięki możliwościom wykonania dobrego zdjęcia w niemal każdych warunkach, dowolnym urządzeniem fotografującym, co jest kolejną zasługą algorytmów sztucznej inteligencji i przetwarzania obrazu, usprawnia się system komunikowania i przepływu informacji. Usprawniają się procesy zachodzące w kontaktach międzyludzkich. Ułatwia się dokumentowanie często dramatycznych wydarzeń codziennych. Wystarczy spojrzeć na finały ostatnich World Press Photo Awards – nie ma tam tylko doskonałych jakościowo zdjęć zrobionych aparatami za dziesiątki tysięcy. Pojawiają się te wykonane pod wpływem emocji, często średniej jakości telefonem – zdjęcia, które by nie powstały gdyby nie oprogramowanie, które jest w stanie obrobić obraz i nadać mu akceptowalną jakość.

Niektórzy oburzają się, że zdjęcie wykonane przez robota, czy obrobione przez algorytmy to już nie dzieło człowieka, tylko maszyny. Inni idą dalej tym tropem twierdząc, że to nie fotograf powinien mieć prawa autorskie do swoich fotografii, a twórcy oprogramowania. Dla mnie są to wierutne bzdury – żadne oprogramowanie nie pójdzie samo w plener o określonej porze, żeby uchwycić wpadające w dolinę światło wschodu słońca. Żadne oprogramowanie nie skomponuje za fotografa kreatywnego, twórczego kadru. Owszem, pomoże z kolorystyką, przeanalizuje scenę, dobierze parametry, ale całe ujęcie jest po stronie fotografującego. Nie można wysnuwać utopijnych teorii o rezygnacji z oprogramowania w fotografii cyfrowej, w przypadku której oprogramowanie jest integralną częścią procesu tworzenia obrazu. Granica w post-produkcji fotografii leży, według mnie, w elementach kompozycji kadru, które podczas obróbki powinny zostać nienaruszone – nie wyobrażam sobie doklejenia lasu, przeklejenia samochodów czy usunięcia np. okien budynku. O ile algorytmy sztucznej inteligencji skupiają się tylko na optymalizacji kolorystycznej i wspieraniu systemów aparatu jak na przykład autofocus, o tyle jest to działanie rozsądne i pożądane.

Najnowsza wersja autorskiego system Eye-AF od Sony – teraz śledzenie oka działa także w czasie rzeczywistym

Wszystkie powyższe przykłady zastosowań algorytmów A.I., uczenia maszynowego czy optymalizatorów obrazu to tak naprawdę tylko wierzchnia warstwa problemu pomagająca zwykłym ludziom w ich codziennym, zwykłym życiu. Cały niniejszy tekst jest, w tym sensie, takim zbiorem wiedzy bezużytecznej, bo co w naszym życiu zmieni świadomość tego jak coś działa i skąd się wzięło? Prawdziwe piękno nauki, wiedzy i jej oddziaływania widać zupełnie gdzie indziej – pod powierzchnią codzienności. W środowisku ludzi nie mogących z jakiegoś powodu sprawnie funkcjonować. Tam niewłaściwe nasycenie zieleni, ograniczone detale w cieniach, czy poruszone zdjęcie nie mają żadnego znaczenia. Dla wielu takich osób możliwość wykonania selfie telefonem, to spełnienie marzeń. Nie są istotne czujniki stabilizacji obrazu, benchmarki procesorów, procesy litograficzne, w których je wykonano, czy turbo szybka pamięć. Te czynniki są tam obecne przez cały czas, ale niejako z boku. Zaawansowane algorytmy nieustannie przeliczają głębię, wykrywają krawędzie nakładają maski segmentacyjne, analizują obraz, po to aby efekt końcowy mógł wywołać uśmiech na twarzy kogoś, kto nigdy nie pomyśli, żeby zostać fotografem, ale marzy, żeby przez krótką chwilę spróbować nim być. Dla wielu osób mierzących się z trudami codziennego funkcjonowania, sztuczna inteligencja wspomagająca rejestrowanie obrazu jest jedynym czynnikiem umożliwiającym utrwalenie chwili i zrobienie pamiątkowego zdjęcia. Nie potrzebują zaawansowanych agregatorów zdjęć, oprogramowania do zarządzania biblioteką danych, bo dla nich każde zdjęcie jest tym jedynym, najważniejszym. To właśnie jest cała istota i piękno sztucznej inteligencji, stworzonej przez ludzi, dla ludzi – działającej w cieniu i ciszy, powodując radość na twarzach i zabierając nas tam, gdzie rodzą się marzenia.

O autorze:

Michał Rozner, ambasador marki SONY w CEWE FOTOJOKER. Trochę fotograf, bardziej filmowiec, absolwent wydziału ekonomiczno-inżynieryjnego na WSZMiJO oraz Executive MBA na Wyższej Szkole Biznesu w Dąbrowie Górniczej. Najszczęśliwszy z plecakiem poza cywilizacją i poza zasięgiem. Humanista, pasjonat.

Michał Rozner, ambasador marki SONY w CEWE FOTOJOKER. Trochę fotograf, bardziej filmowiec, absolwent wydziału ekonomiczno-inżynieryjnego na WSZMiJO oraz Executive MBA na Wyższej Szkole Biznesu w Dąbrowie Górniczej. Najszczęśliwszy z plecakiem poza cywilizacją i poza zasięgiem. Humanista, pasjonat.